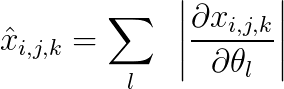

Я ищу эффективный способ вычисления \ hat {x} измерений (bxcxhxw), определенных для выборки как:

, где x - это выход того жеизмерения, сгенерированные моделью с параметрами \ theta и

i, j: индексировать высоту и ширину карты выходных объектов 2D

k: индексирует размер канала

l: индексирует параметры.

Как мне это сделать с помощью x.backward ()?Есть ли эффективный способ сделать это?

Если бы я сделал x.backward (torch.ones_like (x)), я бы вычислил сумму градиентов в приведенном выше уравнении вместо суммы их абсолютныхзначения.

Это можно сделать путем перебора всех пикселей в выходной карте и вычислить .backward ().Но это было бы невероятно дорого.Есть ли эффективный способ избежать цикла?