Я только что закончил свою первую сеть Vanilla Neural и начал изучать сети LSTM. Я много читал и просматривал и нашел две разные идеи о том, как они работают. Это ужасно смутило меня, я надеюсь, что добрые люди из Stack Overflow смогут сказать мне, какой источник полон BS.

1-е объяснение:

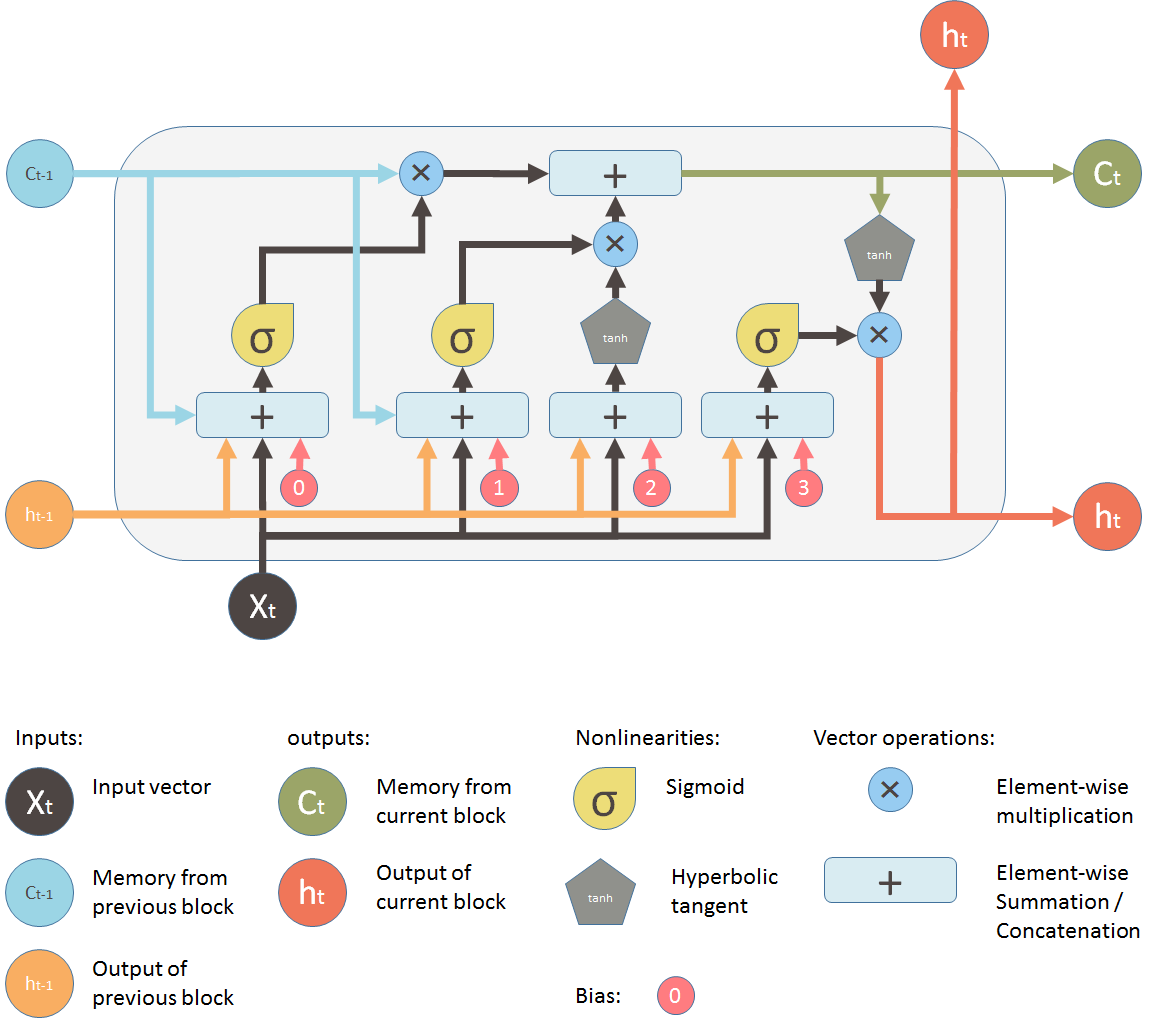

Подобно тому, как в нейронной сети Vanilla есть нейроны, этот источник объяснил LSTM как ту же основную идею с несколькими исключениями. Каждый нейрон заменяется ячейкой LSTM, ячейка имеет автономное состояние ячейки, которое она подает в себя. продолжая мою аналогию с ванильной сетью, я преобразовал бы свою (2,3,2) нейронную ванильную сеть и просто заменил бы все 7 нейронов ячейкой LSTM. Каждая ячейка LSTM будет по-прежнему передавать свои выходные данные с назначенными им весами, но у них будет свое собственное состояние ячейки. Это диаграмма, которую они дали.

2нс Объяснение:

Это второе объяснение то, что действительно смутило меня. Он объяснил ячейку LSTM как целую систему, главное отличие в том, что в его примере в ячейку LSTM встроены 4 ванильные нейронные сети, а в другом примере - нет.

Если кто-то может сказать мне, что является правильным, или почему они отличаются, я был бы очень признателен!