Это вопрос, чтобы глубже понять двигатель скрапа. На моем сервере я могу запускать несколько процессов очистки параллельно (процесс очистки можно запустить с помощью API-интерфейса Scrapy или просто запустив процесс Scrapy в командной строке).

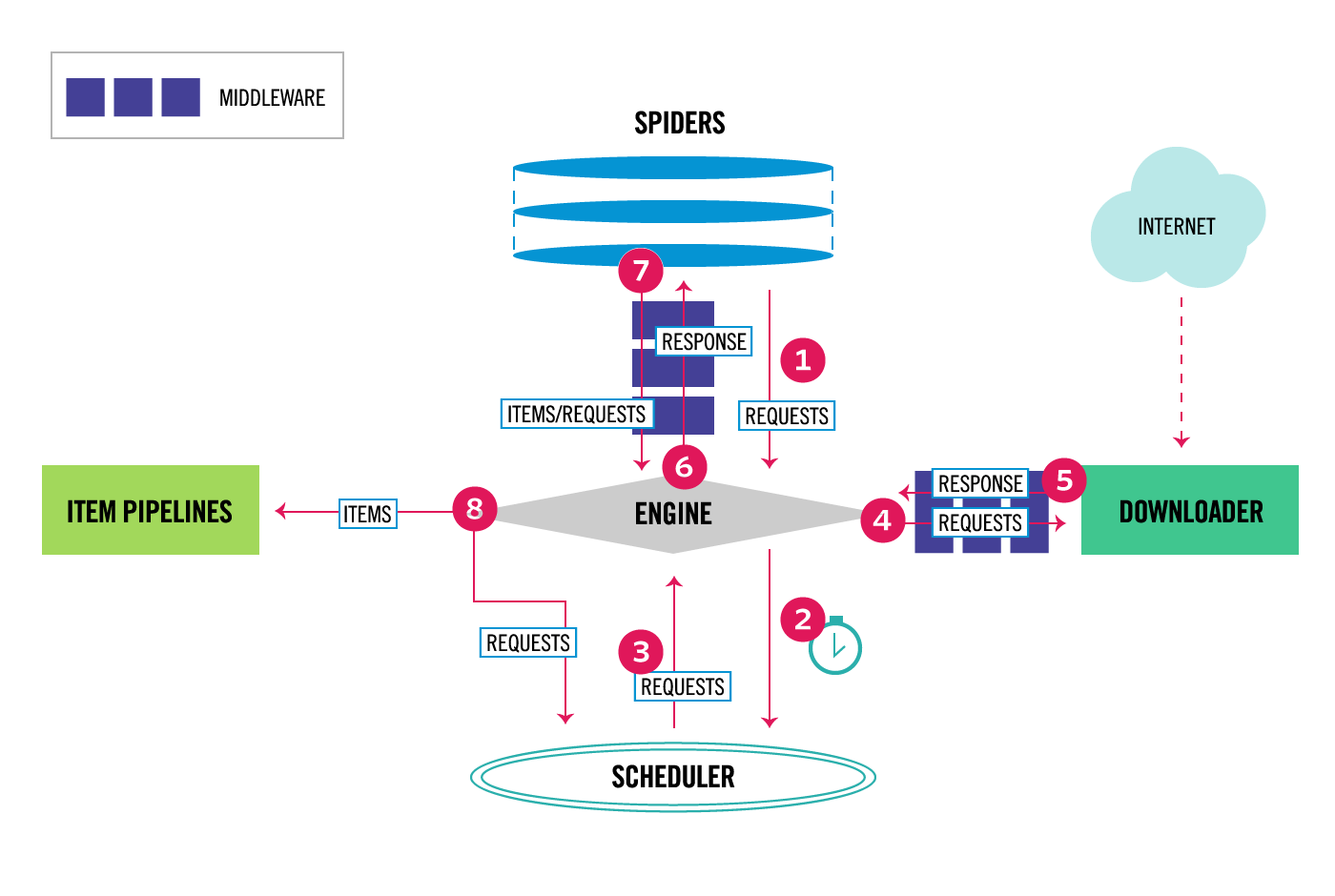

Звучит хорошо, но давайте обратимся к следующей фотографии архитектуры scrapy:

Насколько я понимаю, у каждого процесса очистки будет свой собственный движок, планировщик, загрузчик и т. Д. Существует возможность указать / настроить процесс обработки для одновременного выполнения нескольких обходов.

Означает ли это, что если я приказываю каждому процессу выполнять 50 запросов параллельно, мой сервер будет выполнять 100 запросов параллельно (потому что у меня запущено 2 процесса). Вот еще несколько вопросов, которые у меня есть:

- Как лучше всего научить скрапу проводить параллельные обходы?

- Должен ли я определить все URL-адреса в начальных URL-адресах, и тогда планировщик scrapy автоматически планирует для меня сканирование или есть другой способ?

- Есть ли документация по планировщику?

- Меня немного больше интересует, как именно работает планировщик и как распараллеливаются обходы?

- Где должны быть определены URL, чтобы scrapy выполнял параллельные запросы?

Спасибо за ответы на мои вопросы.